案例介绍

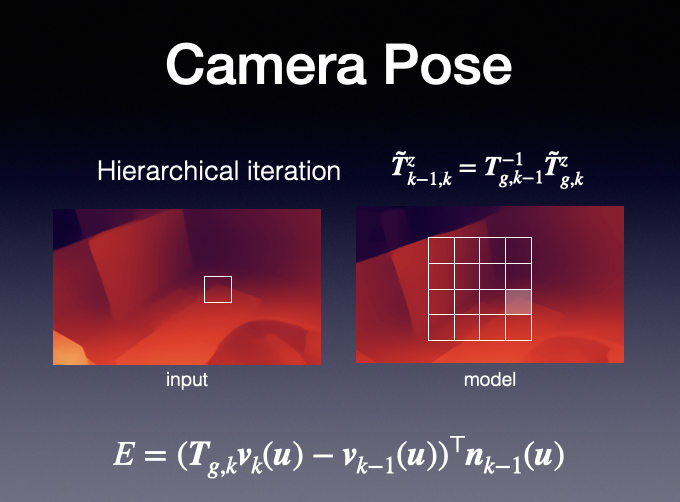

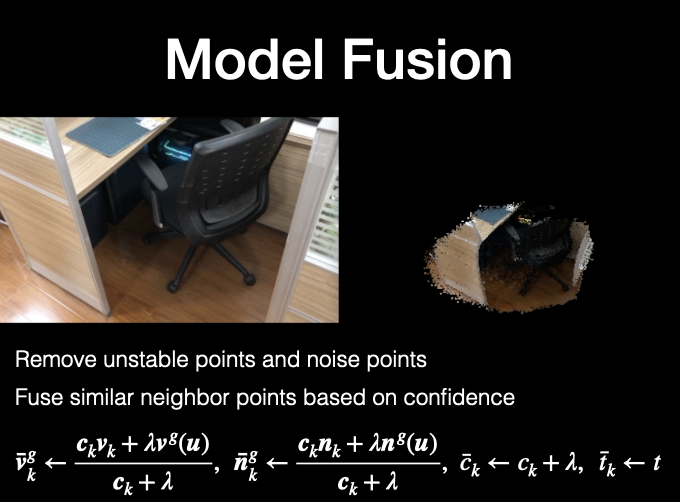

本文提出了基于单目RGB图像序列的重建算法,实现了一个从二维图像转化到三维模型的系统,并在实验中对比分析了使用不同深度估计网络和重建方法的效果差异。与现有以深度图作为输入重建算法不同,本算法仅以彩色图像作为输入,不需要任何先验模版和相机参数信息,输出基于点的三维面片模型。算法分为两个部分:第一个部分使用神经网络从单幅图像中估计出稠密的伪深度,然后基于多幅图像之间的几何一致性对深度图像序列进行校正;第二个部分首先基于几何上一致的深度图,使用点到面最优的迭代算法估计相机位姿,然后投影细节更丰富的未校正图像至全局空间,基于点的可见置信度融合面片模型。实验结果表明,本文提出的使用两种深度进行联合重建的方法在静态场景上是可行的,与单一深度输入的重建算法相比,可以获得更高的鲁棒性以及更多的细节。

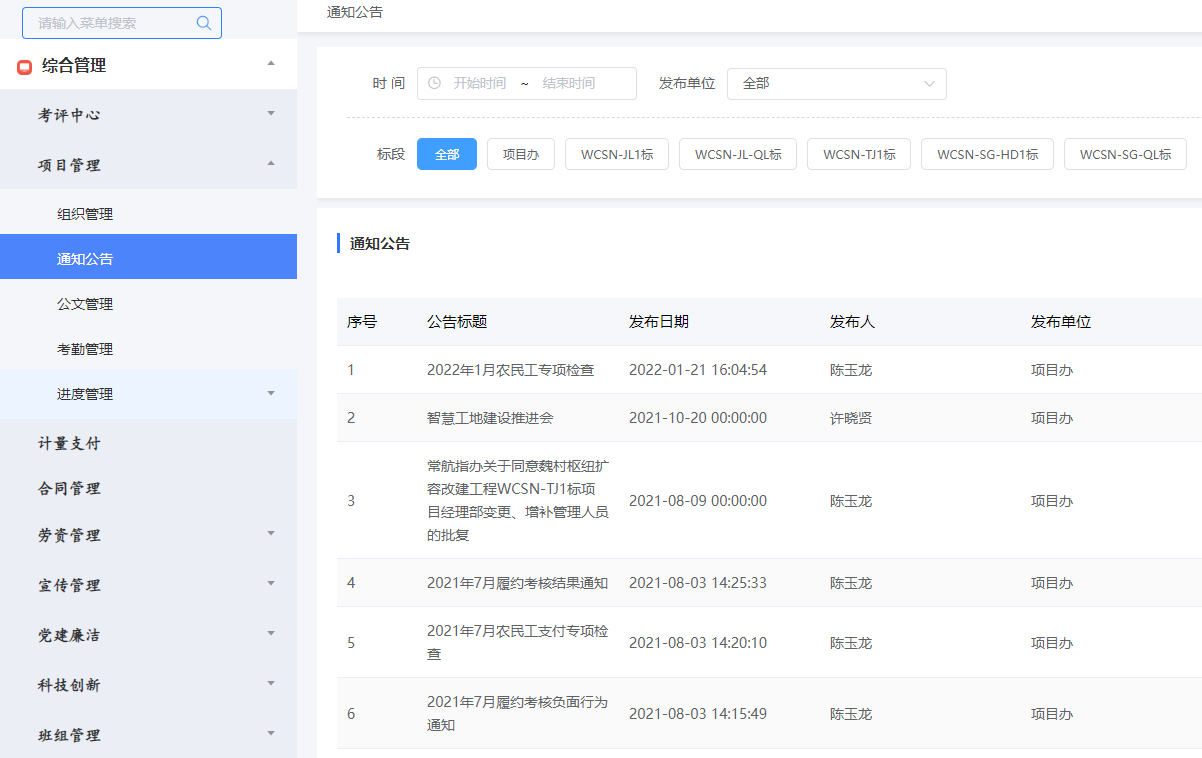

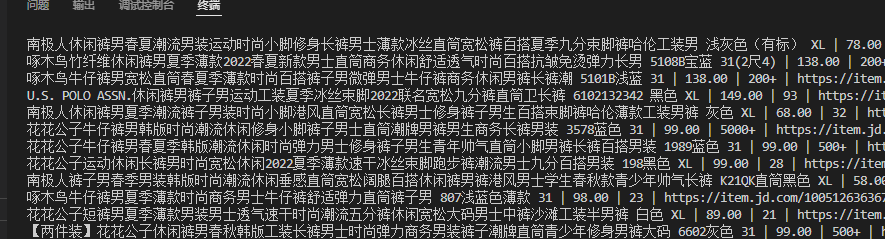

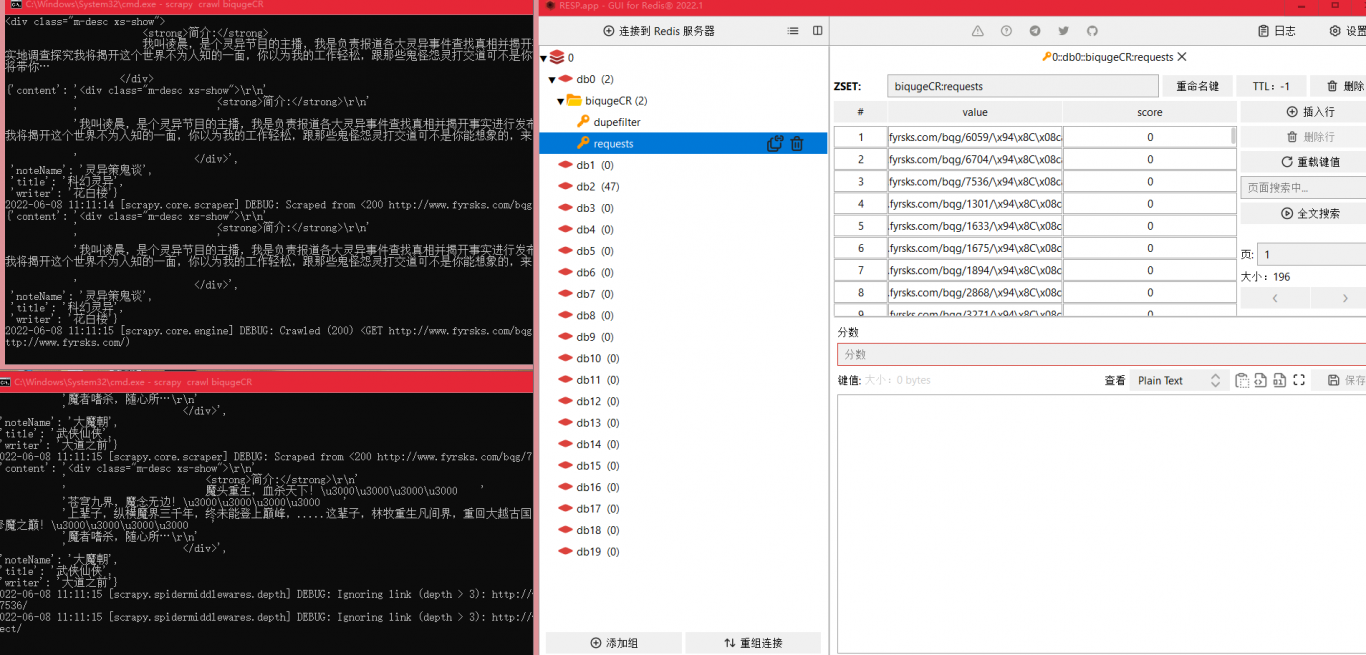

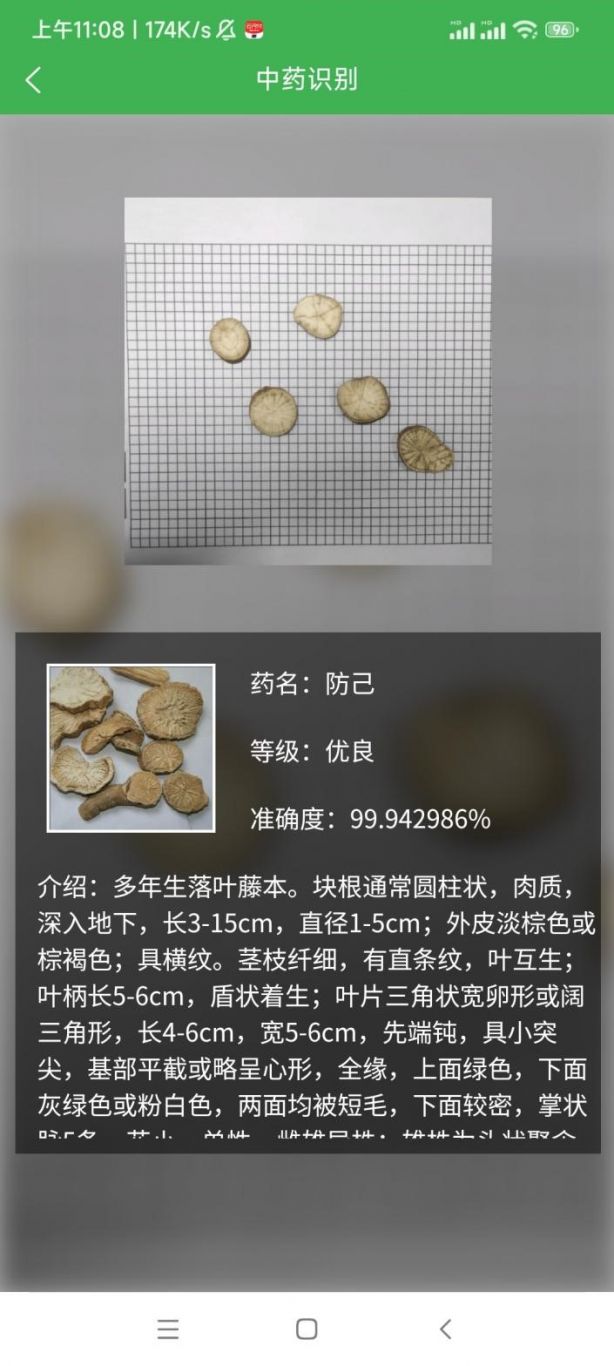

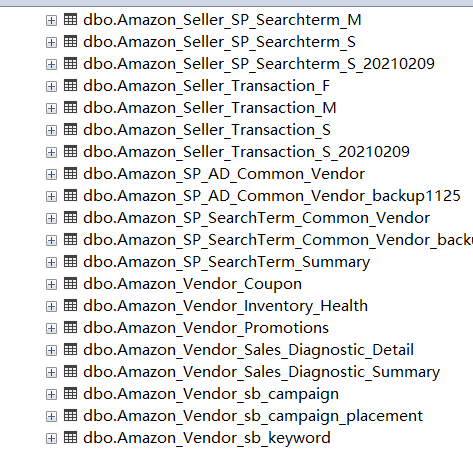

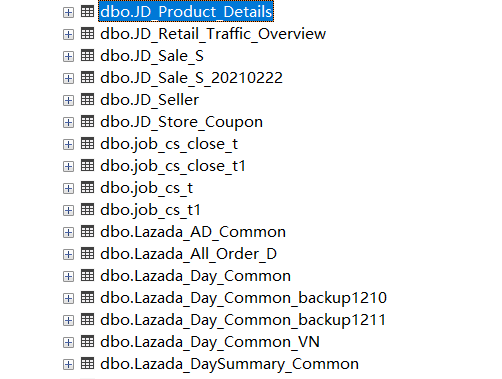

案例图片