微博用户UA实时流数据处理

案例介绍

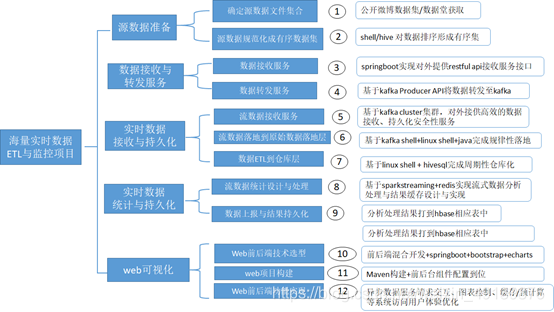

根据采集工程师实时爬取到的微博数据,实时传输到数据接收服务平台,形成微博博文数据,构建,基于该微博平台实时数据的相应数据仓库,同时做好相应的数据监控工作,用于及时发现数据潜在问题,例如数据暴增骤减等情况,以及其他潜在数据开发需求

具体需求说明

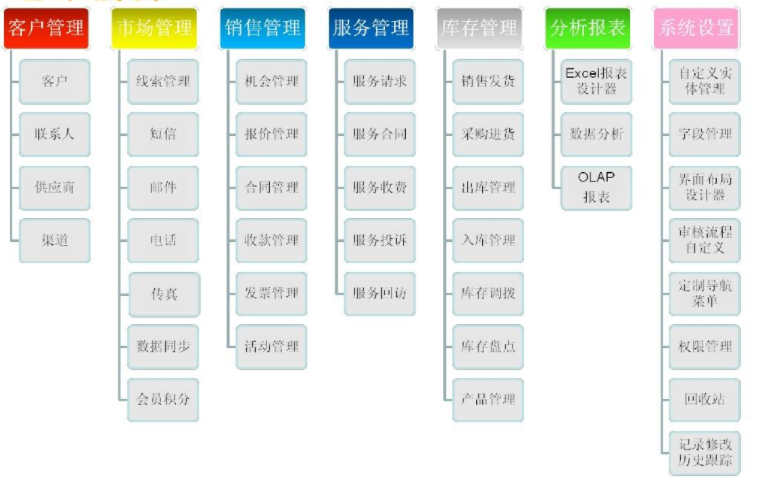

构建实时数据流仓库

以小时为单位,构架小时级的实时数流数据仓库

数据监控工作

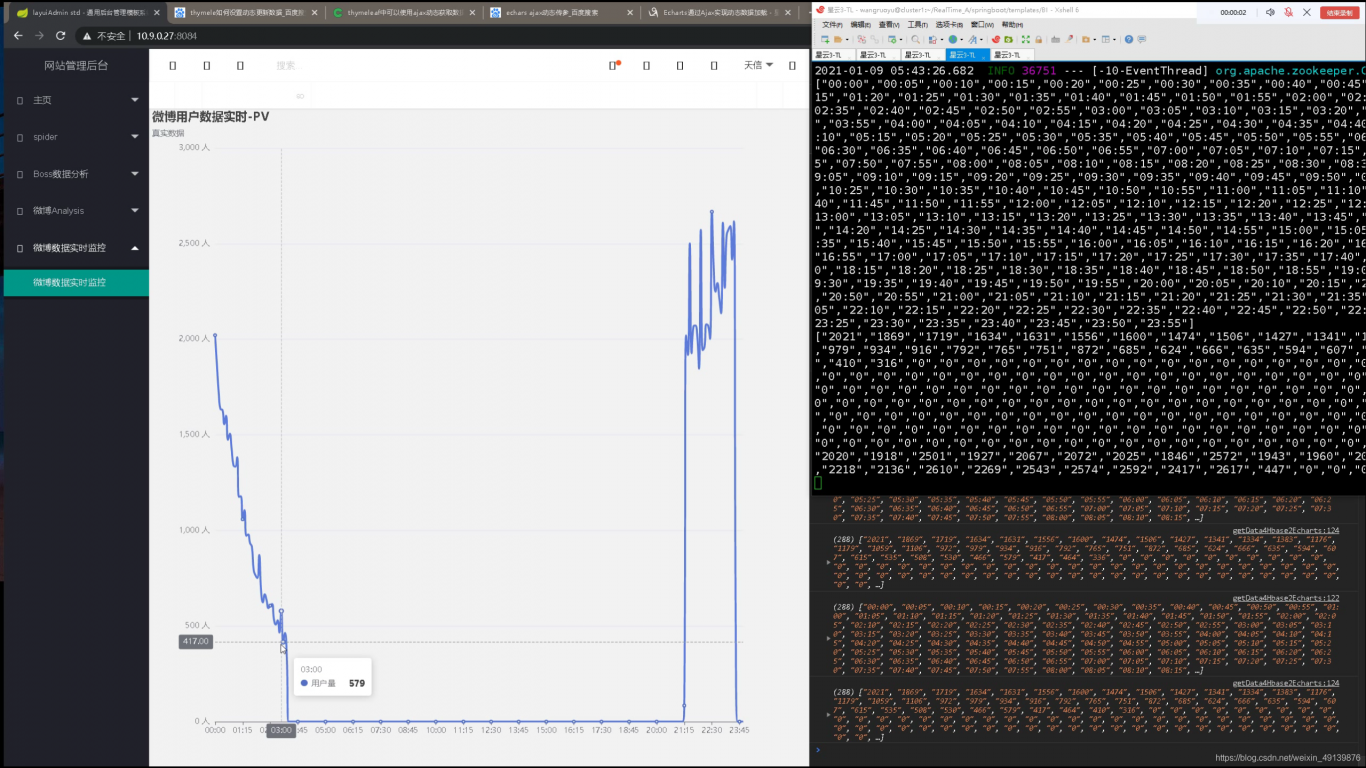

以天和小时数据为维度,来做数据记录数据维度的分钟级,小时级,天级监控,最后通过echarts进行实时变化的曲线图,进行可视化展示

Product Requirement Docunment

从业务逻辑角度,讲清楚,如何做,

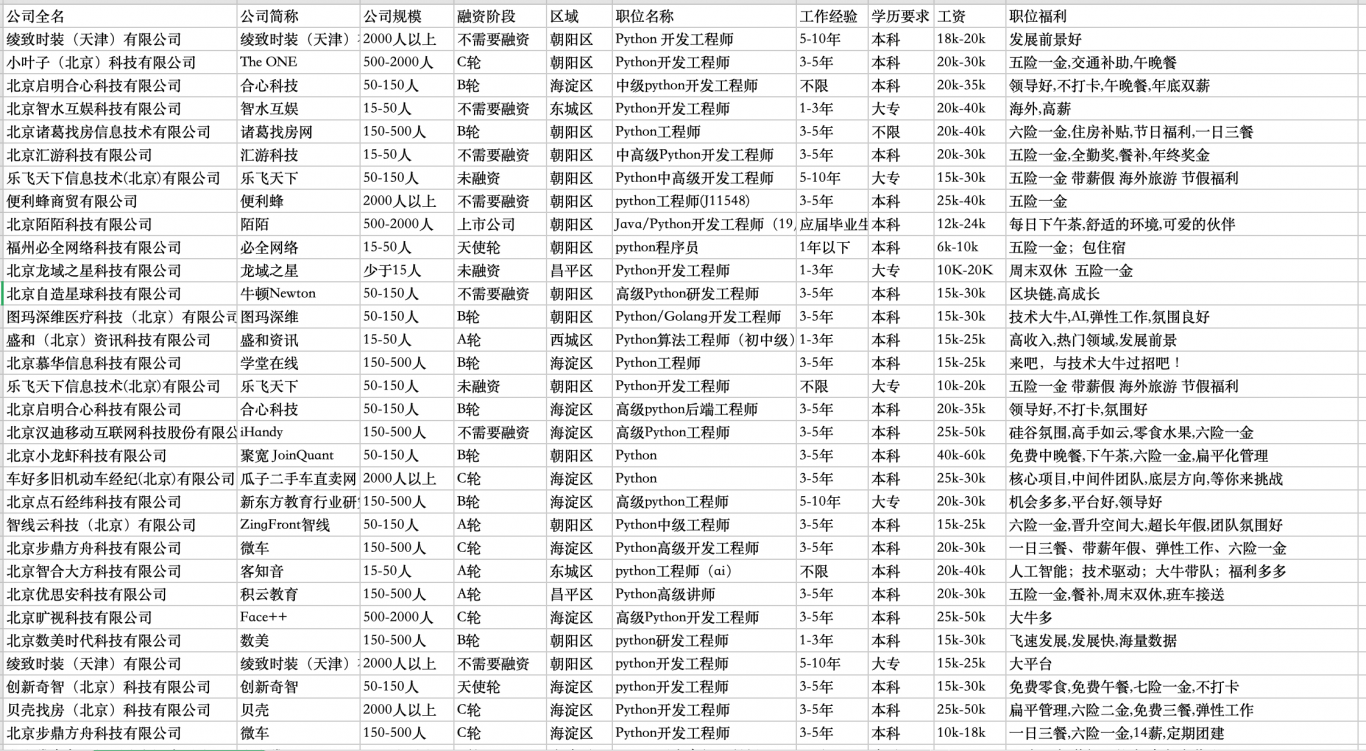

持续提供具有时间连续性,时间有序性的数据流,文章总数不低于100w条,实际给出2.2亿条数据

数据格式:csv

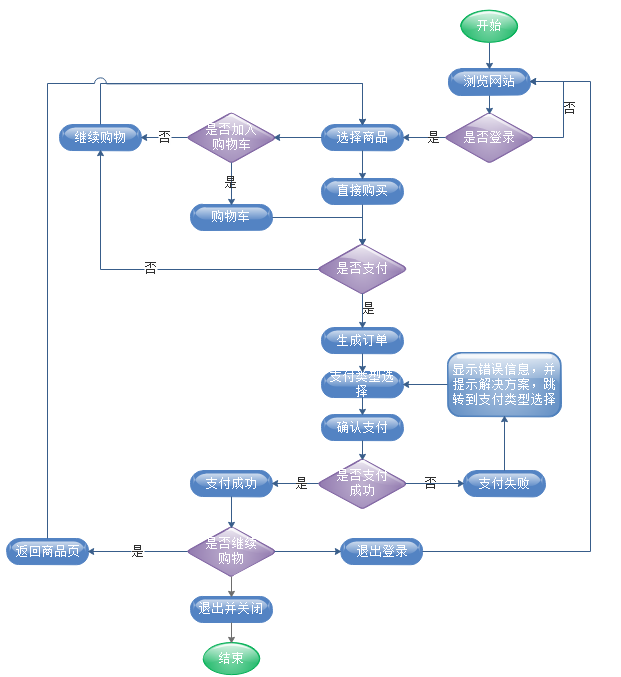

将数据流纳入实时数据流疫情处理分析,得到如上需求所需要的数据源

将实时数据流落地,攻坚hive微博小时级实时数据仓库

并对试试数据流进行分钟级,小时级别,天级别的监控,将数据实时上报到关系型数据库

将数据推送到mysql/hbase指定表格中

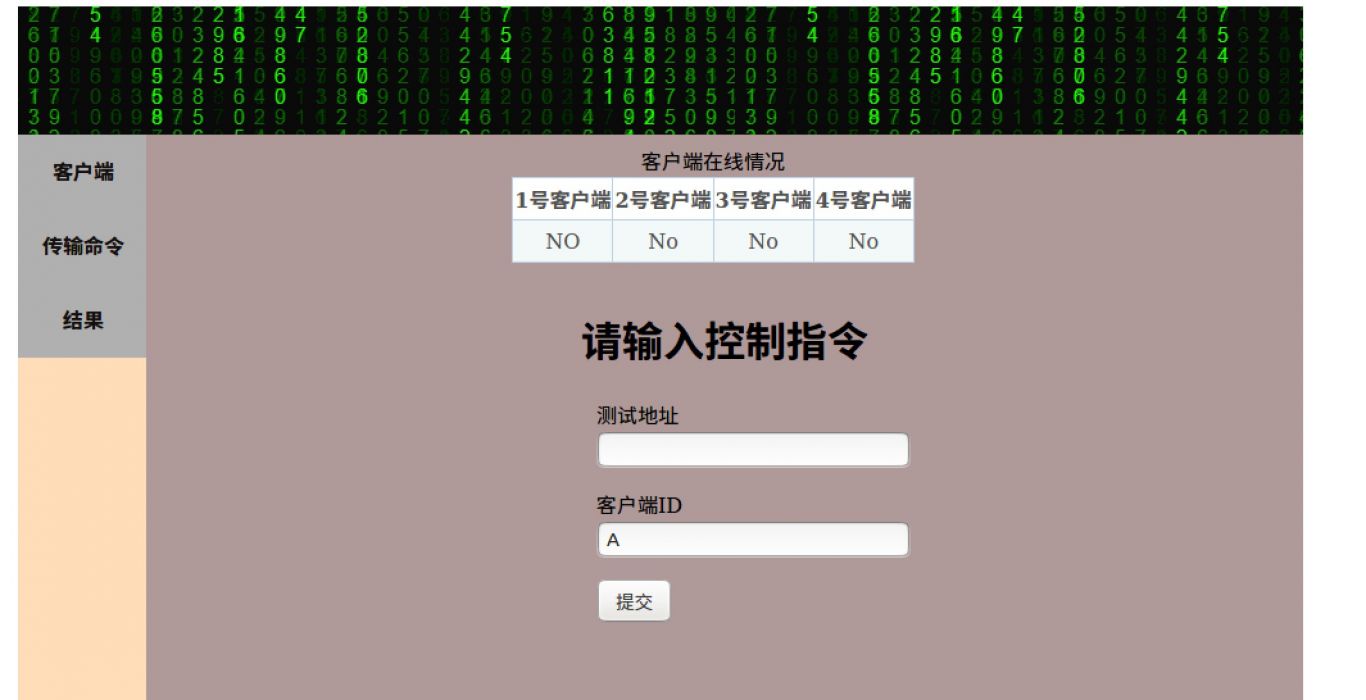

搭建java web项目,在前段页面中调用后端数据接口,将数据返回到前端中

在前段调用绘图插件,并展示

明确阶段目标和验收标准

风险控制与过程管理

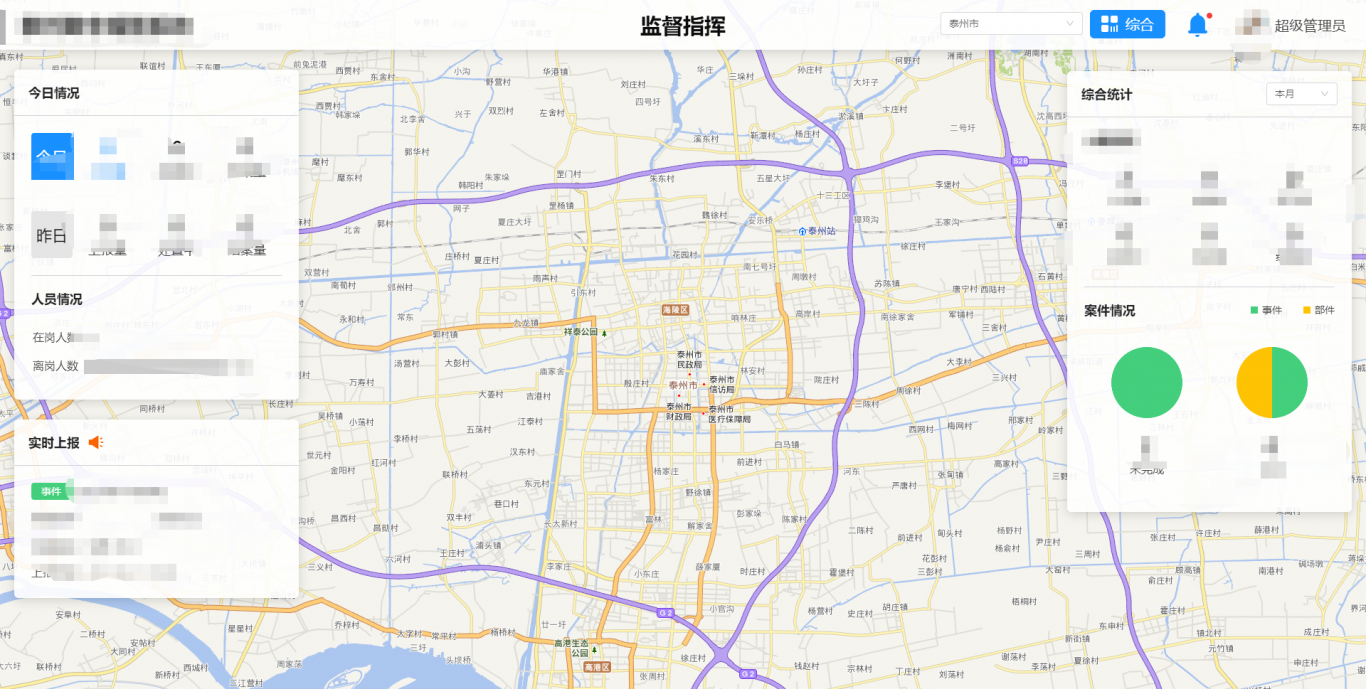

案例图片