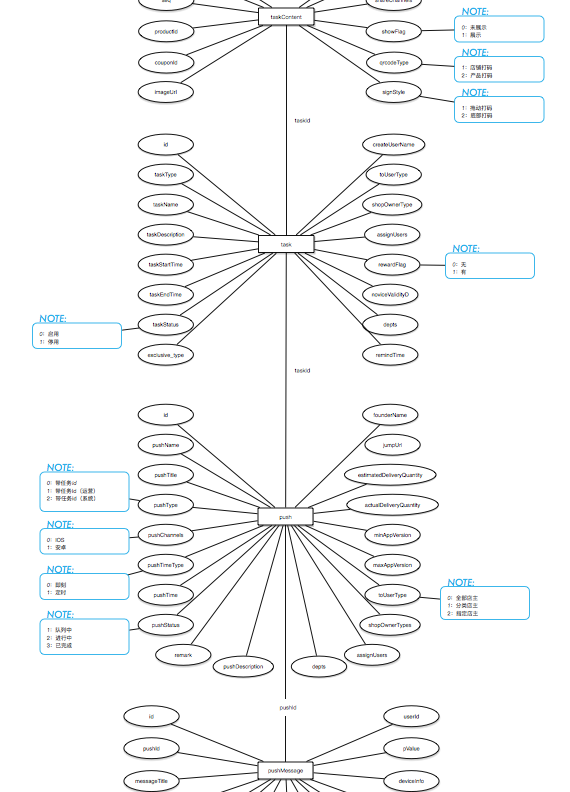

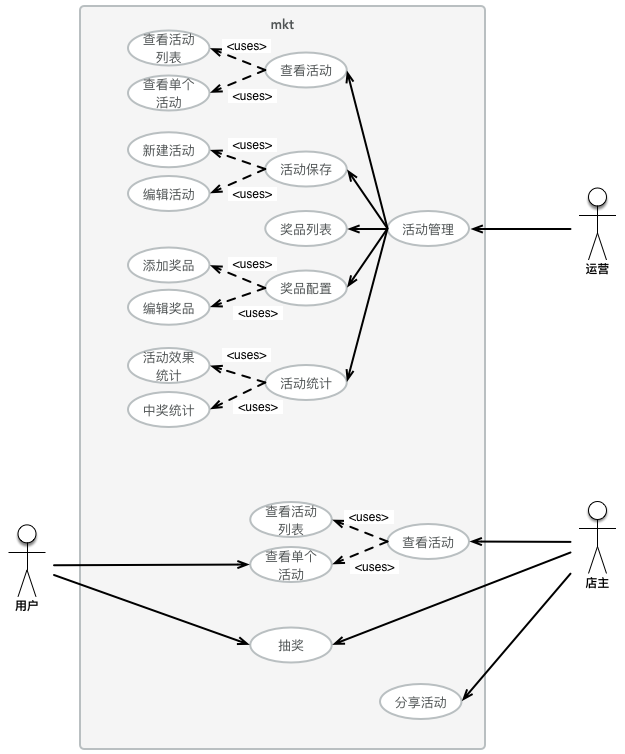

案例介绍

定时从数据库读取实时数据,每次请求读取10000条记录。

对读取的数据进行归类后保存到本地日志,并同步日志数据到elk服务器。

发送查询请求到elasticsearch服务器,查询最新30分钟和前一天的日志数据。

比较两份日志数据,并把差异数据记录到本地日志,然后通过filebeat同步日志到elk服务器。

如果监测到数据超过正常阈值,则发送邮件告警。

核心api监控

本地建立tcp服务器接受来自logstash输出的应用日志。

服务器对日志数据进行url过滤,并计算每个http请求的访问时间,访问次数等。

对一系列api请求分析结束后,发送解析数据到elk服务器。

发送数据有失败重试机制,原理是失败请求存储到redis队列,间隔5s重试一次

案例图片