案例介绍

1.数据采集阶段-b站发现爬虫采集会封IP 使用代理IP 用时大概一周获取1500万数据

2.数据库sqlite3

3.启动run(URL+[i for i in range(1,1997*10000)]) 开启延迟避免封IP,判断code!=0

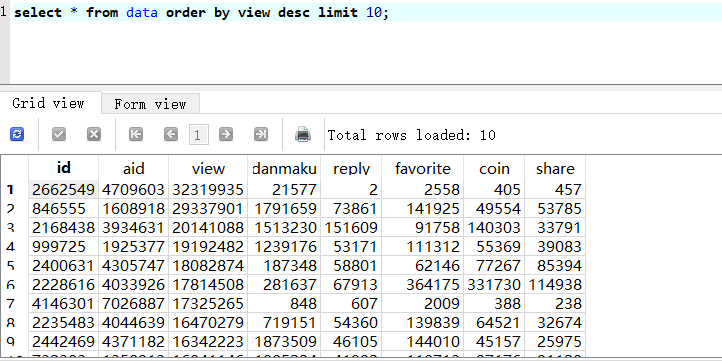

获取aid(视频编号),view(播放量),danmaku(弹幕数),reply(评论数),favorite(收藏数),coin

(硬币数),share(分享数),保存本地,报错保存logging

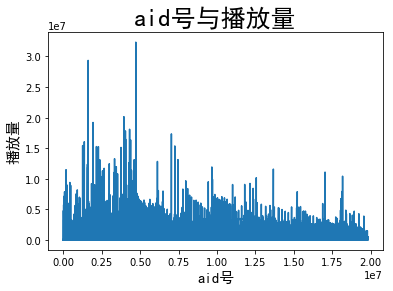

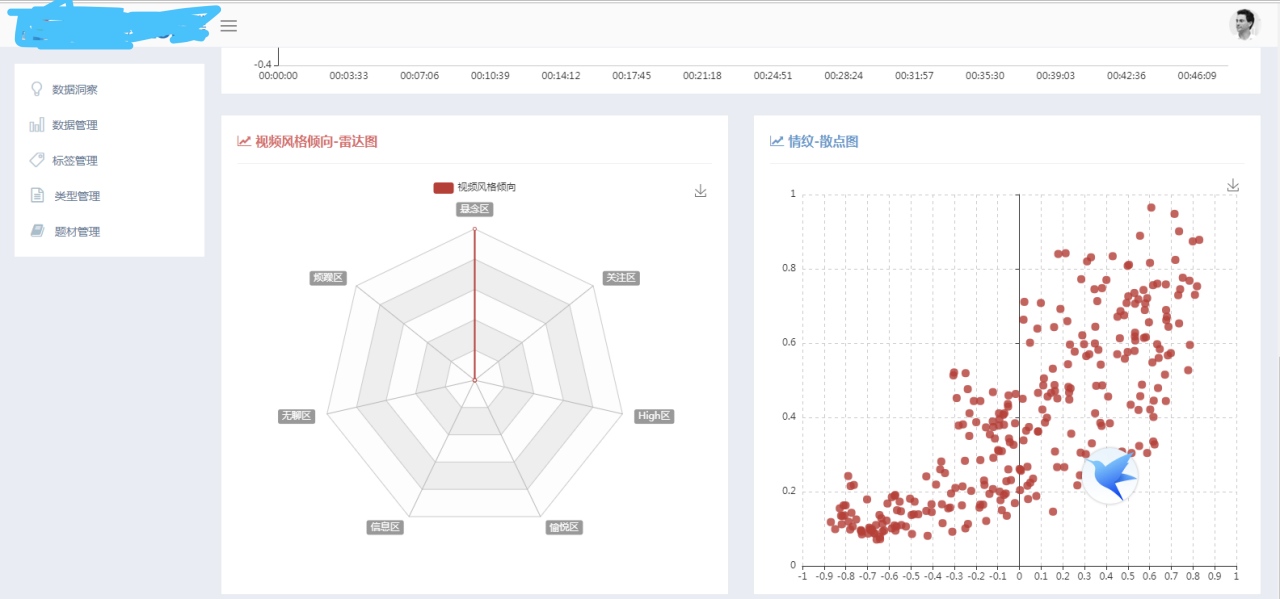

4.Pandas+sqlite3+matplotlib 分析数据关系,aid与播放量,收藏与硬币数,查询播放

量前10,查询收藏前10

案例图片