案例介绍

智源&计算所虚假新闻挑战赛的task1 False News Text Detection 初赛成绩 top-4,复赛成绩 top-12

模型无特别之处,直接用的LM base (roBERTa 和 XLNet),科大讯飞训练的版本

用large的batchsize太小效果不如base,机器好的请忽略

在保证截断长度能覆盖大部分数据的情况下,batchsize越大越好,这里截断长度192,batchsize24,差不多11G显存跑满

大部分模型evaluate的情况都是FN比FP要高几倍,投票策略单纯五五开的话效果不理想(10折单模初赛线上只有0.89左右)

所以投票策略应该侧重于提高正类的召回

用投票完的结果作为脏标签最后再过一遍训练,结果能辅助稳定提升3-4个千分点(无论在初赛还是复赛)

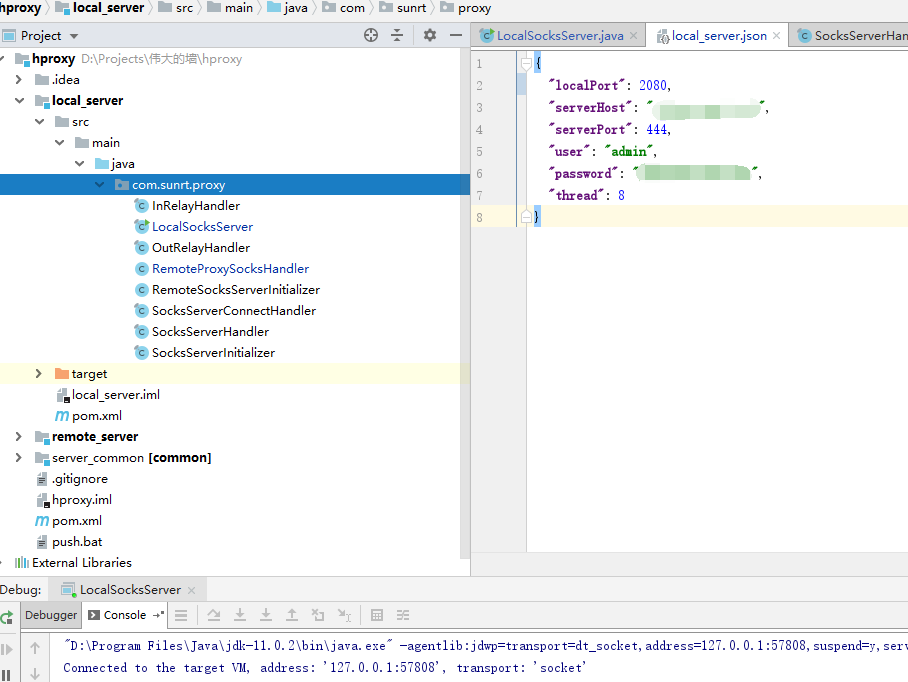

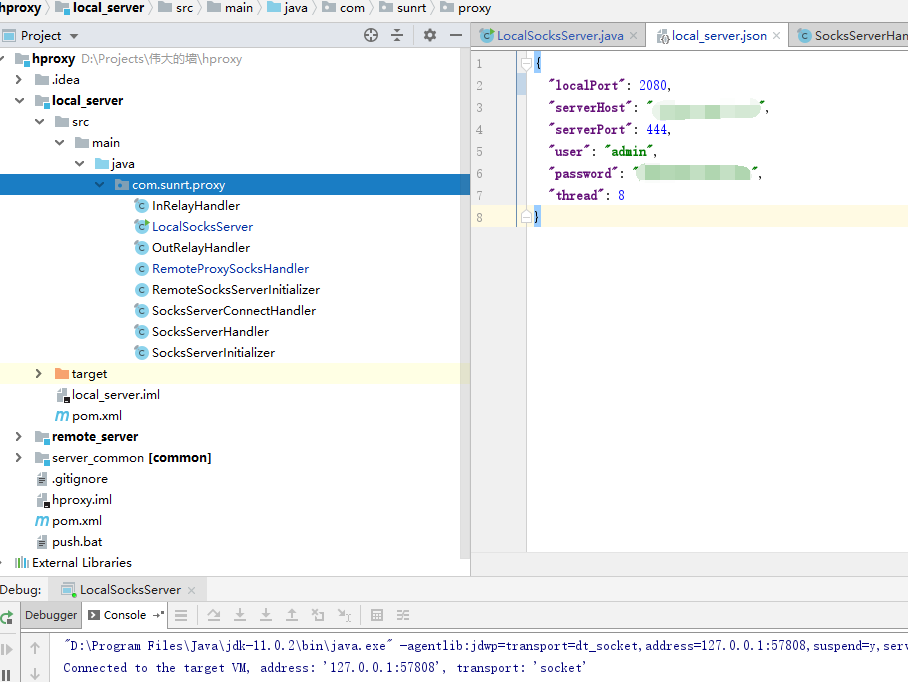

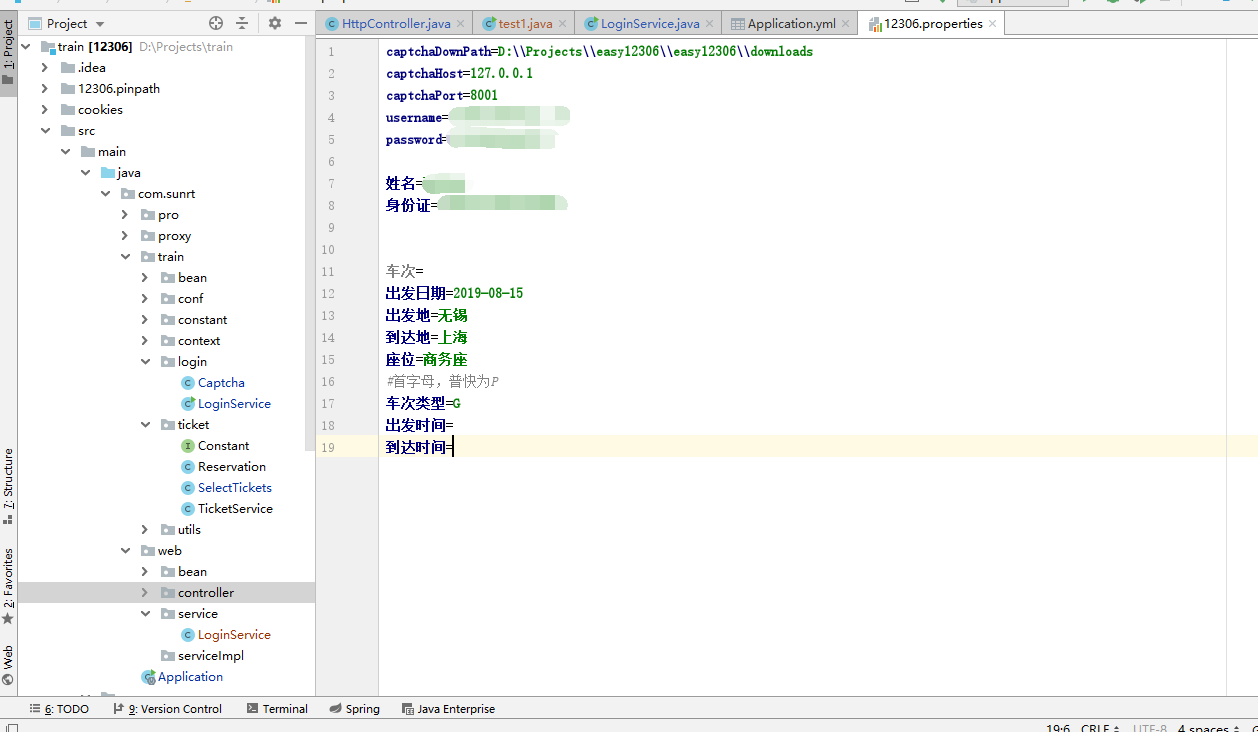

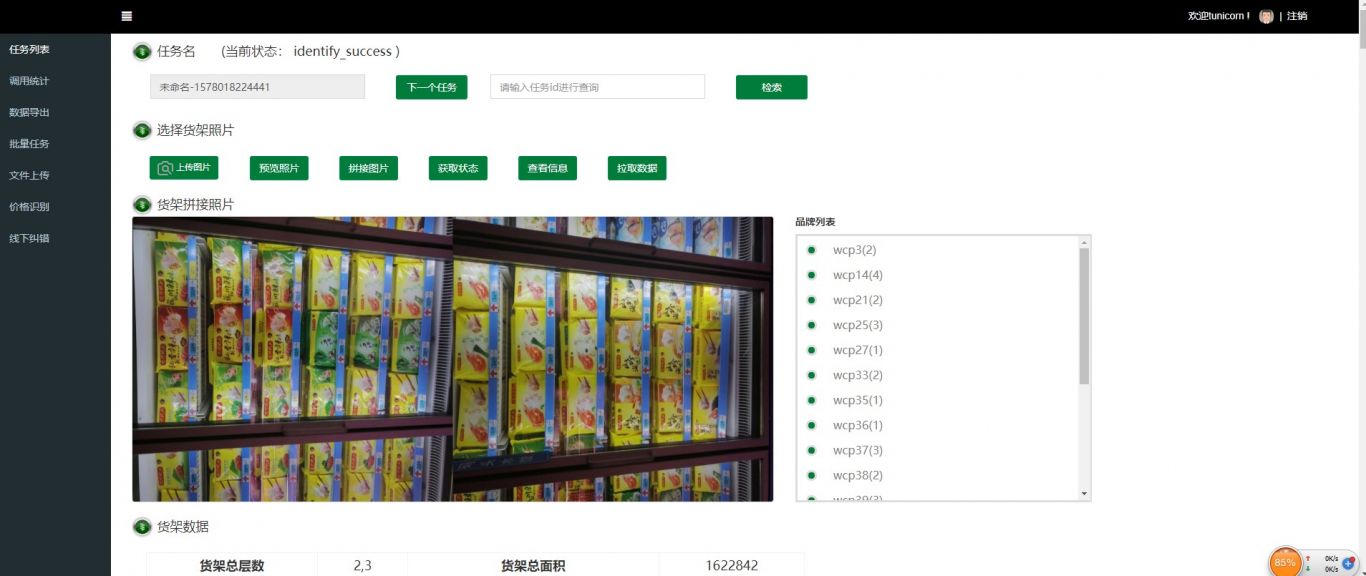

案例图片