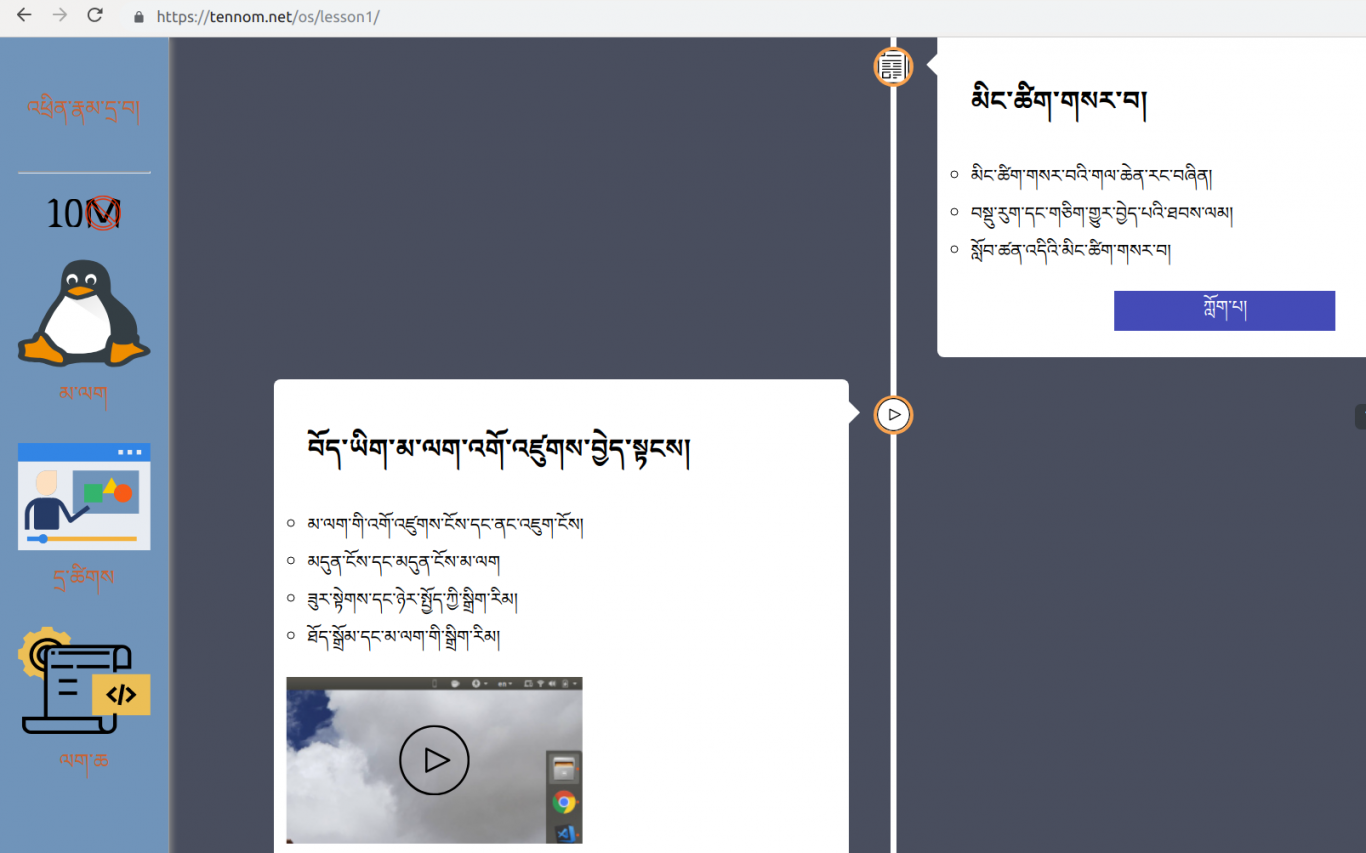

案例介绍

爬虫相关使用

使用requests爬取相关页面,lxml解析页面,使用xpath或者re来匹配内容

使用selenium爬取相关动态页面,通过id/name/xpath定位元素,send_keys,click,get_attribute,转换窗口等等。

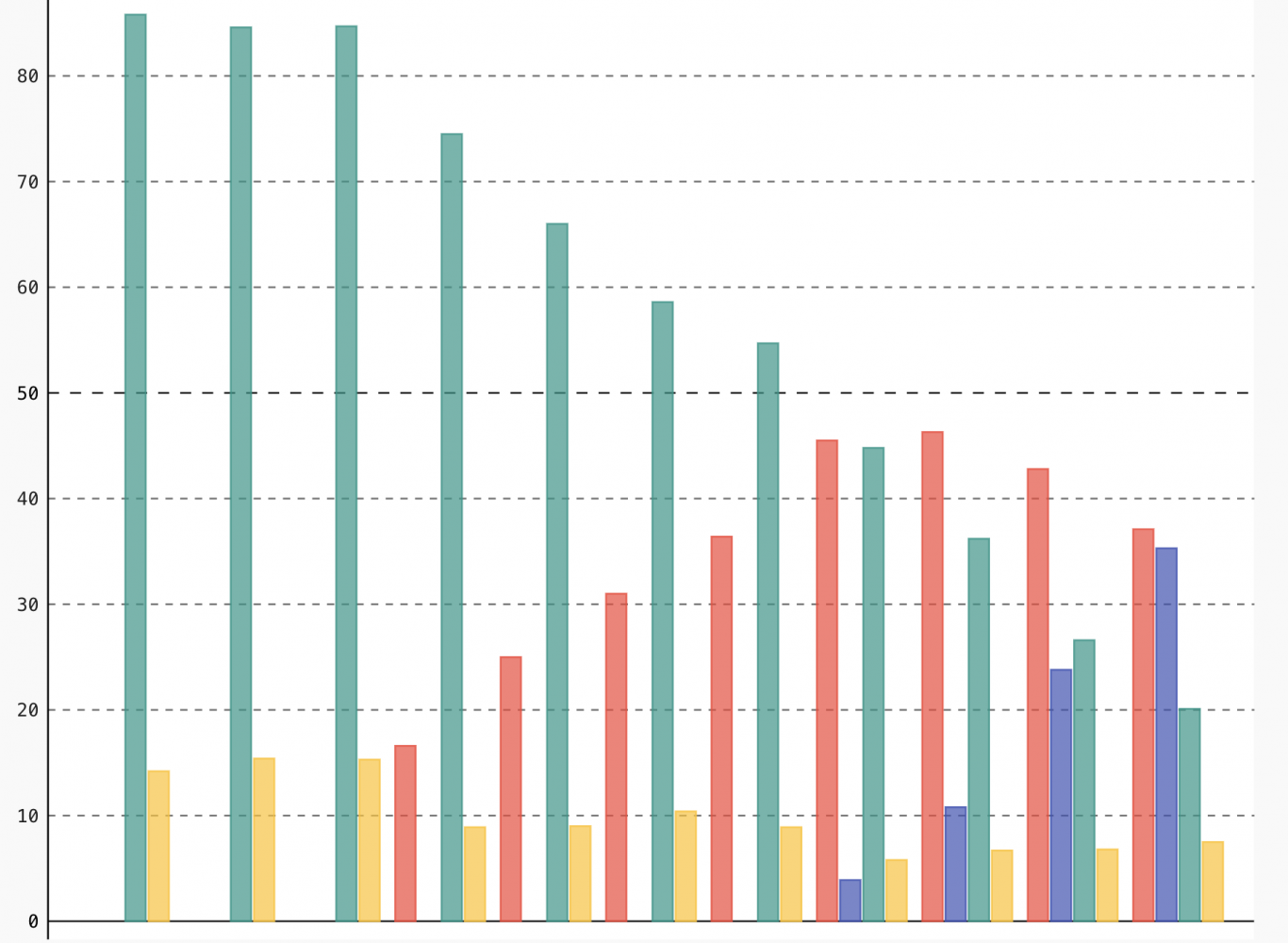

同时也会基本使用pandas进行数据分析,pygal进行可视化展现,pillow进行基本图像处理

爬虫遇到问题

User-Agent/ip等问题,可以通过伪造User-Agent,构建ip池

爬取Google的扩展程序时候,相关信息在response的主体并没有爬到相关东西,最后在head中找到并批量爬取信息

使用requests爬取某些页面,出现SSLError,当时临时解决方案是使用verify=False来忽略SSL验证,后来根据安装requests的security extras可以解决,不过在v2ex里面看到也有使用证书的。

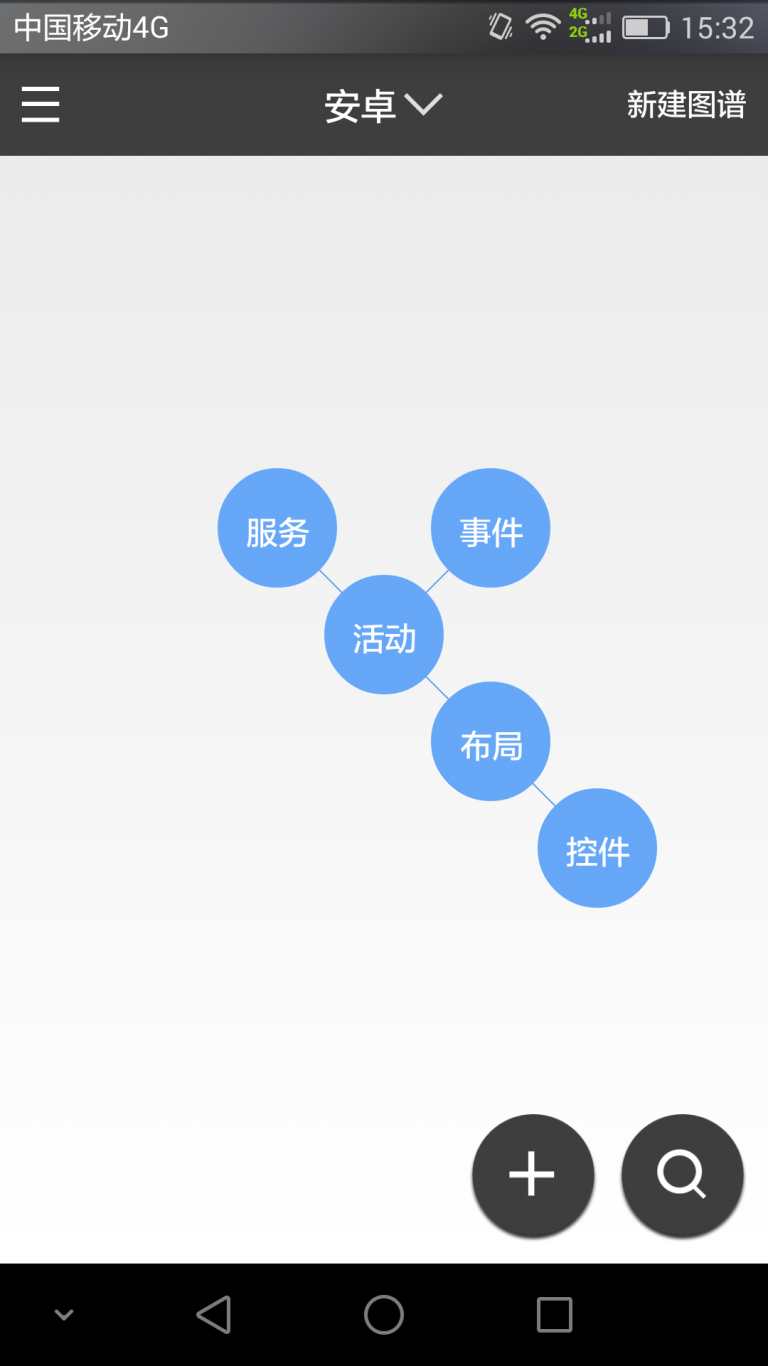

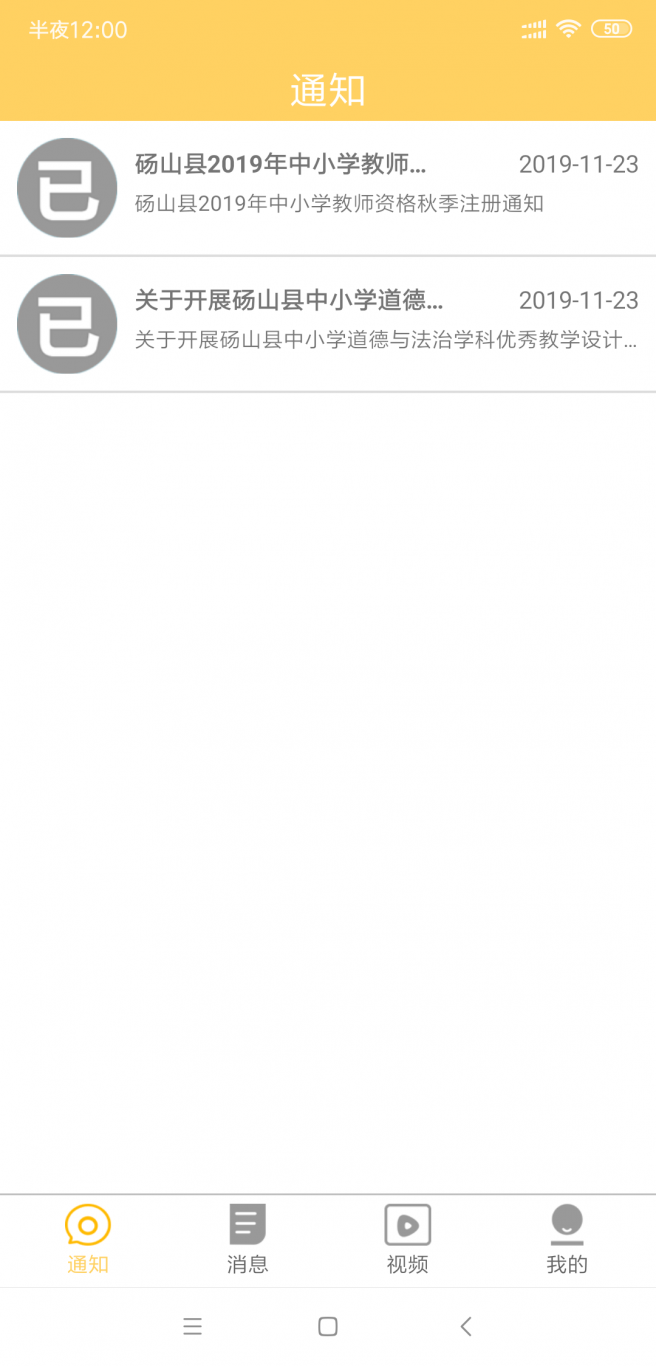

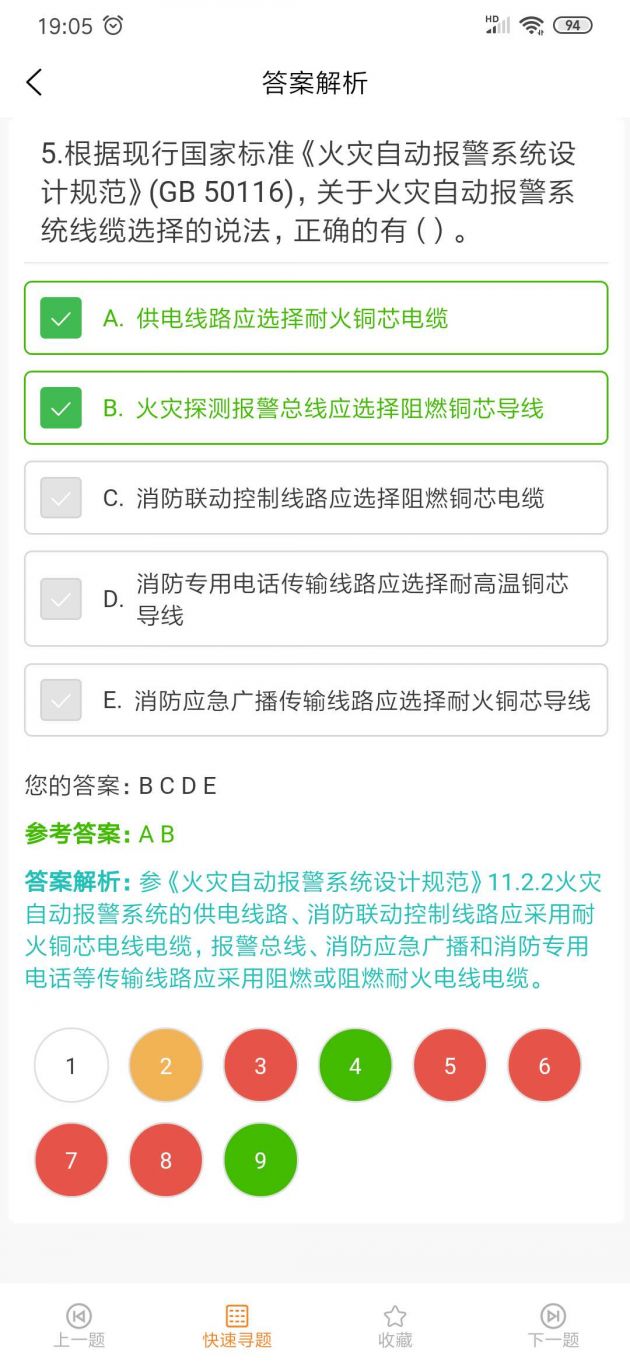

案例图片